Originariamente pubblicato in data 03/08/2008

A

C

C

O

M

A

Z

Z

I

Intel ha 40 anni

Compie 40 anni in questi giorni una delle icone della rivoluzione informatica personale: Intel, casa che produce la stragrande maggioranza dei microprocessori che stanno al cuore dei moderni personal computer.

Compie 40 anni in questi giorni una delle icone della rivoluzione informatica personale: Intel, casa che produce la stragrande maggioranza dei microprocessori che stanno al cuore dei moderni personal computer. Una azienda, dunque, più anziana di Apple (appena trentenne) o Microsoft (che ne ha trentatre): anche perché senza Intel certamente non ci sarebbe stata Microsoft e probabilmente non ci sarebbe stata Apple.

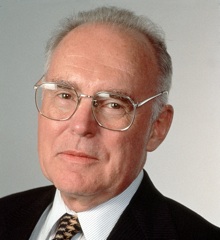

L'uomo simbolo di Microsoft è certamente Bill Gates, neopensionato di lusso, ed è impossibile immaginare l'iPod e il Macintosh senza la visione di Steve Jobs. Per Intel la storia comincia con Gordon Moore, fisico, nel 1965: un nome forse meno conosciuto rispetto ai due summenzionati, ma comunque passato alla storia per la prosaica "legge" che porta il suo nome. Proprio nel 1965 Moore osserva che ogni due anni mediamente raddoppia la capacità dei circuiti integrati (alla base sia delle memorie che dei processori, allora come ora). Con l'amico Robert Noyce, tre anni più tardi nel 1968, Gordon Moore fonderà la Integrated Electronics. Non è un successo immediato: il fatturato del primo anno è di soli 2672 dollari, lasciando l'azienda con circa tre milioni in debiti.

Il primo vero prodotto esce nel 1969 e con esso nasce il simbolo di Intel, il logo con la "e" più in basso rispetto alle altre lettere (recentemente sostituito dal meno memorabile svolazzo quasi-circolare). Il primo oggetto a uscire dalle fabbriche Intel è un chip di memoria RAM (ad accesso casuale, cioè la stessa che ancora oggi memorizza programmi e documenti aperti nei moderni PC). Per anni ed anni le memorie saranno il prodotto principale della casa californiana di Santa Clara, mentre i primi circuiti capaci di elaborare i dati presenti in quelle memorie verranno strategicamente concepiti soltanto per spingere consumi ancora più imponenti del prodotto principale.

La rivoluzione italiana

Nel 1970 Intel assume uno scienziato italiano, Federico Faggin, inventore del processo che permette l'allineamento automatico dei gate nei circuiti integrati. Faggin comincia una vera e propria lotta all'interno dell'azienda. Gli altri dirigenti, compreso Moore, pensano che Intel debba progettare su misura un nuovo processore specializzato ogni volta che un cliente presenta una necessità specifica: se il cliente deve sommare rapidamente numeri, gli si costruirà un veloce sommatore; se deve produrre apparecchi che tengono sotto controllo il minimo e il massimo di una temperatura gli si fornirà un circuito del tutto diverso. Faggin invece sostiene a spada tratta la necessità di standardizzarsi su un prodotto unico, flessibile e universale. Riesce a portare a casa una commessa per un gran numero di calcolatrici da una azienda giapponese, la Busicom, e comincia lo sviluppo. È così che nel 1971 nasce lo Intel 4004, il primo microprocessore integrato della storia, capace di lavorare su numeri a 4 bit (in pratica, da un minimo di zero a un massimo di quindici). Potrebbe sembrare poco oggigiorno, quando nei più modesti portatili si annida un processore a 64 bit miliardi di volte più veloce, ma ai tempi il 4004 sembrò, ed effettivamente fu, una conquista. In quel chip grande quanto l'unghia di un pollice stavano le stessa capacità di un ENIAC,. che nel circa vent'anni prima era stato il primo computer della storia. Dal 4004 nacquero i successori a otto bit chiamati 8008 e 8080, e il processore a sedici bit 8086, che stava nel cuore del primo PC IBM, il nonno di tutte le macchine Windows moderne.Faggin lascerà Intel a fine 1974 per proseguire lo sviluppo di altri microprocessori, ma con Gordon Moore saldamente al timone la casa di Santa Clara continuerà ad essere il protagonista indiscusso del mercato dei microprocessori. Nel 1972 Moore apre uno stabilimento in Malesia, facendo di Intel la prima multinazionale dell'informatica personale, un titolo mai avocato ad altri, basti pensare che oggi Intel ricava solo il 20% del suo fatturato negli USA, mentre per Apple questa componente vale circa il 50% (Microsoft, dal canto suo, non rivela la composizione geografica dei suoi introiti).

Il mercato

Lo 8086 si dimostrerà indiscutibilmente una benedizione per Intel. Il (tutt'altro che geniale) piano di IBM era quello di usare il PC come piede di porco per introdurre l'informatica negli uffici e nelle piccole imprese, convincendo titolari e responsabili dell'utilità del calcolatore in impresa. La speranza era che, a quel punto, certamente costoro avrebbero abbandonato il limitato "personal computer" in favore di un vero, costosissimo, potente calcolatore aziendale. Le cose andarono ben diversamente: si vendettero PC a vagonate, le limitazioni che IBM aveva volutamente inserito nel PC lo resero facile da copiare e clonare, nacquero aziende come Compaq che riuscirono a realizzare PC dapprima più economici e poi persino più veloci di quelli IBM. Ne guadagnarono Intel, i cui chip stavano al cuore di tutti i PC, e Microsoft che vendette a tutti il suo sistema operativo.Nel tempo, la famiglia 8086 darà anche seri grattacapi ai manager Intel, provocando tre crisi, la più recente delle quali non è ancora superata ad oggi. Il primo problema si manifesta già alla fine degli anni Settanta: le altre aziende produttrici di circuiti integrati si ingolosiscono nel vedere il lucroso mercato dei microprocessori e cominciano a creare <span style= "font-style:italic;" >chip</span> differenti eppure compatibili con quelli Intel. È AMD la azienda più aggressiva in questo campo, e ben presto diviene la arcirivale della casa di Santa Clara, sfornando un processore compatibile con lo 8080. Ancora oggi gli AMD sottraggono fette di mercato a Intel e alimentano una continua corsa alla miglioria, talvolta persa dalla azienda di Gordon Moore (che, per esempio, arrivò seconda al traguardo del primo microprocessore capace di oltre un miliardo di micro-operazioni per secondo).

Piano con le innovazioni

Ancor più spinoso si rivelerà il secondo problema. Ben presto infatti gli ingegneri della società di Santa Clara si renderanno conto che il mercato pretende da loro processori sempre più veloci eppure sempre compatibili con i loro predecessori. Nessuno acquista un processore solo per avere capacità di calcolo teoricamente stupende: le aziende vogliono continuare ad utilizzare i programmi che hanno acquistato nel tempo e che sono costati fior di quattrini e mesi e mesi di sviluppo e rodaggio. Molti miglioramenti tecnologici che sarebbero teoricamente possibili agli architetti dei chip vanno dunque scartati a priori e non possono venire sfruttati. Di conseguenza, i processori Intel perdono colpi rispetto ai concorrenti di differente e incompatibile architettura. Per il suo primo Macintosh, nel 1984, Apple sceglierà un processore Mototola, quasi due volte più potente; nel 1991 passerà ai processori IBM chiamati PowerPC, che in seguito verranno scelti anche da Sony per Playstation e persino dalla stessa Microsoft per Xbox 360.La soluzione escogitata dai manager Intel a questi indubbi problemi è coraggiosa e lungimirante: investire, investire e investire ancora, per restare alle vette della tecnolgia. Intel oggi spende sei miliardi di dollari ogni anno ricerca e sviluppo, il 17,5% del suo fatturato. Appaiono assai minori in confronto le pur notevoli spese di Apple e Microsoft, al 3,3% e 11,5% rispettivamente. I risultati però si vedono, e Intel porta come una medaglia sul petto la conversione dei calcolatori Macintosh di Apple alla proprie tecnologie, avvenuta nel 2006.

I flop e i problemi per il futuro

Non tutte le strade tentate dalla azienda di Santa Clara si riveleranno un successo. Per cercare di smarcarsi dalla pensante eredità dell'8086, gli ingegneri Intel produrranno nel 2001 un processore, lo Itanium, che è caratterizzato da una logica drasticamente differente da quella 8086. Era compatibile con i processori precedenti, ma piuttosto lento nell'eseguire il codice pensato per essi. L'Itanium venne pensato nella speranza che i programmatori cominciassero a sviluppare software per la nuova e moderna architettura, e che gli utenti lo adottassero nel frattempo considerandolo una soluzione accettabile per i programmi esistenti. Nessuna delle due cose però accadde: Itanium fu un colossale flop sia per Intel che per Microsoft, la quale provò a sviluppare una versione di Windows per quel processore e ne restò invischiata al punto che oggi la casa fondata da Bill Gates sta mantenendo quelle che in pratica sono tre differenti versioni di Windows: la versione a 32 bit per processori Intel classici, quella per Itanium e quella per processori a 64 bit di architettura AMD, recentemente e a malincuore adottata anche da Intel. Secondo molti commentatori è questo uno dei maggiori motivi del fallimento di Windows Vista, la mediocre versione del sistema operativo che la maggior parte degli utilizzatori evita.Oggi Intel procede a gonfie vele, ma deve affrontare, come anticipavamo sopra, una nuova problematica, che ironicamente il suo fondatore aveva previsto negli anni Sessanta. (Gordon Moore ha lasciato nel 2001 il timone di Intel, ed ora è presidente emerito della azienda.) La famosa legge di Moore, quella che prevedeva un continuo raddoppiamento delle velocità di elaborazione, si è scontrata con un limite fisico: la velocità della luce. Per quanto siano brillanti, gli ingegneri Intel non possono far scorrere gli elettroni nei fili a una velocità maggiore. Di conseguenza, i chip prodotti dal 2006 in poi contengono in un unico componente elettronico più di un processore; anzi, sino a otto (e AMD ha annunciato da pochissimo un modello a dodici nuclei di elaborazione). Questo modo di procedere è eccezionale per tutti gli utenti che eseguono contemporaneamente otto o dodici programmi sui loro PC, ciascuno dei quali potrà godere di un elaboratore tutto suo. Disgraziatamente per Intel, la maggior parte di noi fa già fatica a lavorare con una applicazione informatica la volta, e gli sviluppatori di software fanno una gran fatica a immaginare come un loro singolo programma possa dividersi su due o più processori per terminare le elaborazioni nella metà del tempo. Le menti migliori di Intel (e Microsoft e Apple) sono al lavoro su questa problematica; se verrà risolta e se la legge di Moore non ci abbandona, attorno al 2020 i processori Intel avranno raggiunto la medesima complessità di un cervello umano. Che cosa sarà loro possibile a quel punto, nessuno può dirlo.